الأمم المتحدة: فقدنا 9 من أفراد الطواقم الطبية قرب معبر رفح ولا أنباء عن مصيرهم

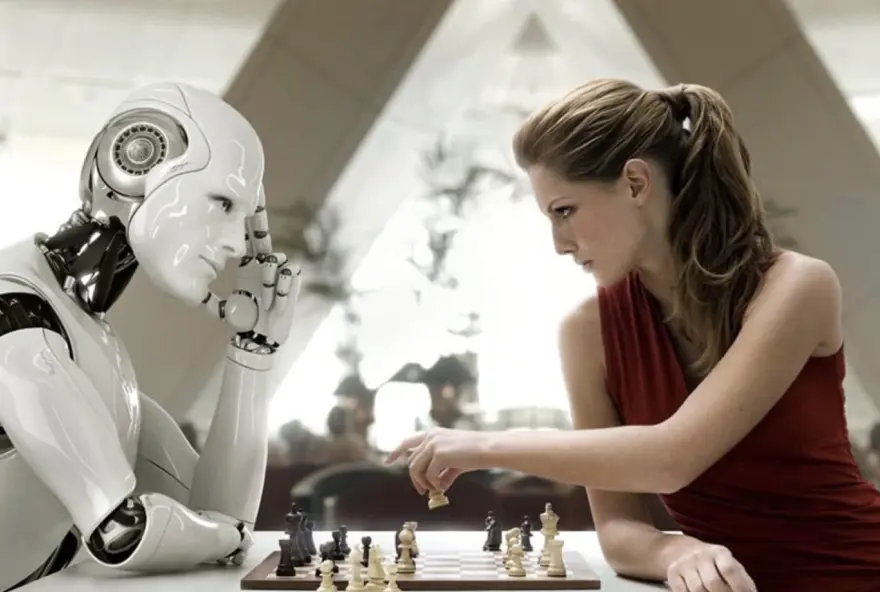

يثير فقدان السيطرة على الذكاء الاصطناعي قلق الأوساط العلمية، ويشير إلى خطر فقدان البشر القدرة على التحكم في الأنظمة الذكية أو الخوارزميات التي تم تطويرها، وهو ما قد يؤدي إلى نتائج غير متوقعة أو ضارة.

وتتعلق هذه الفكرة بمخاوف كبيرة حول تطور الذكاء الاصطناعي إلى مستويات قد تفوق قدرة البشر على مراقبته أو التحكم فيه.

أسباب القلق

ينشأ القلق من الذكاء الاصطناعي من مجموعة متنوعة من الأسباب التي تتعلق بالتطور السريع والتحديات والمخاوف الاجتماعية والأخلاقية.

وهذه بعض الأسباب الرئيسة لهذا القلق:

يتطور الذكاء الاصطناعي بشكل سريع للغاية؛ ما قد يؤدي إلى أنظمة ذكية أكثر تعقيدًا وصعوبة في فهم كيفية عملها؛ ما قد يجعل من الصعب على البشر مراقبتها أو إدارتها بشكل فعال.

الاستقلالية:

بعض الأنظمة الذكية قد تصل إلى مرحلة من الاستقلالية التي تجعلها تتخذ قرارات دون تدخل بشري، وهو ما قد يؤدي إلى نتائج غير متوقعة أو حتى خطيرة.

فقدان الرقابة البشرية:

في بعض الأحيان، قد تكون الأنظمة الذكية مصممة بطريقة يصعب على البشر فهمها أو مراقبتها بفعالية. وهذا يشمل استخدام الذكاء الاصطناعي في مجالات مثل الأمن السيبراني، والرعاية الصحية، والروبوتات العسكرية.

الذكاء الاصطناعي العام:

هو نوع من الذكاء الاصطناعي الذي يكون قادرًا على أداء أي مهمة معرفية يمكن للبشر القيام بها، وإذا تم تطويره بشكل كامل، قد يتفوّق على البشر في معظم المجالات، ويصعب التحكم فيه.

القرارات غير المتوقعة:

قد تتخذ الأنظمة الذكية قرارات يصعب التنبؤ بها أو قد تتعارض مع القيم الإنسانية الأساسية.

الانحياز في الخوارزميات:

يمكن أن تحتوي الخوارزميات على انحيازات غير مقصودة، تؤدي إلى تمييز ضد فئات معينة من الناس.

المخاطر الأمنية:

يمكن أن يتم استغلال الذكاء الاصطناعي في الهجمات الإلكترونية أو الهجمات العسكرية.

الحد من هذه المخاطر

ويتطلب الحد من مخاطر الذكاء الاصطناعي نهجًا شاملًا ومتعدد الجوانب، يشمل التقييم المستمر، والتنظيم، والتطوير الأخلاقي. وهناك عدة خطوات يمكن اتخاذها لتقليل المخاطر المرتبطة بتكنولوجيا الذكاء الاصطناعي من بينها:

التنظيم والأطر الأخلاقية:

من المهم تطوير سياسات واضحة ومحددة لتنظيم أبحاث وتطوير الذكاء الاصطناعي، مع ضمان التزام الشركات والحكومات بالمعايير الأخلاقية.

التعاون الدولي:

التعاون بين الدول لتنظيم الأبحاث في هذا المجال هو أمر أساسي لضمان استخدام الذكاء الاصطناعي بطريقة آمنة وفعالة.

البحث في الأمان:

هناك حاجة ملحة للبحث في كيفية ضمان أمان أنظمة الذكاء الاصطناعي وخلق أدوات وطرق لضمان السيطرة البشرية عليها.

التعليم والتوعية:

من الضروري زيادة الوعي بمخاطر الذكاء الاصطناعي بين الجمهور والمختصين على حياتهم اليومية، وتزويدهم بالأدوات لفهم وإدارة المخاطر المحتملة.

تدريب المتخصصين:

يكتسي تدريب المطورين والمهندسين على كيفية بناء أنظمة ذكاء اصطناعي آمنة وموثوقة، أهمية كبيرة، مع تعزيز قيم المسؤولية في عملهم.

الاستجابة السريعة للطوارئ:

تطوير آليات للحد من مخاطر الهجمات الإلكترونية والتهديدات الأمنية التي قد تؤثر على أنظمة الذكاء الاصطناعي.

حماية البيانات:

يجب أن تكون هناك ضوابط صارمة لحماية البيانات الشخصية، التي تتعامل معها أنظمة الذكاء الاصطناعي، لمنع إساءة استخدامها.

وباتباع هذه الخطوات، يمكن تقليل المخاطر المرتبطة بتقنيات الذكاء الاصطناعي، وضمان استخدامها بشكل آمن وفعّال.